纸飞机app中文版下载官网

token搜论文,token analysis

Tokens的含义 在论文中,Tokens通常指的是文本分析中的最小单位它是经过分词处理后得到的单个词汇或符号简单来说,Tokens就是文本中的一段段小片段,这些片段可以是单词数字符号等在进行自然语言处理或文本分析时,Tokens是极其重要的分析基础详细解释如下一分词与Token形成过程文本通常需。

文章讨论了在大型语言模型LLM滥用的背景下,通过添加水印来缓解可能引发的问题作者提出了一种巧妙的方法,通过随机选取一个“绿色”token集合,鼓励模型输出来自该集合的token,实现低成本隐式的文本水印在框架内部,检测水印的方法无需提前获取LLM的API或模型参数,基于统计方法即可分析水印的存在。

在Fox的论文中,团队进一步提升文档视觉感知理解的上限,通过高密度信息压缩,使模型能够真正“看”懂图像,并做出实际可用的文档多模大模型一个图像令牌one image token远超一个文本令牌one text token的表述方式,体现了图像在信息传达中的重要性实战中,Fox展示了其对中英混排单栏多栏组。

在prefixtuning之前的工作主要是人工设计离散的template或者自动化搜索离散template,问题在于最终的性能对人工设计的template的特别敏感加一个词或者少一个词,或者变动位置,都会造成很大的变化,所以这种离散化的token的搜索出来的结果可能并不是最优的因此斯坦福的研究人员于2021年通过此论文PrefixTun。

论文网站的登录注册和其他网站都是大同小异的今天就谈谈怎么实现的吧首先我们看登录逻辑 1第一次登录的时候,前端客户端调后端服务器的登陆接口,并发送用户名和密码 2后端服务器收到客户端请求,验证用户名和密码,验证成功,就给前端客户端返回一个token 3前端客户端。

目前,在image caption的评测中,常用的指标如BLEUnMETEORCIDEr存在一些主要缺陷为了解决这些问题,近期的研究从预训练模型的角度提出了一些新的评测指标其中,BERTScore是一个有效的解决方案该指标通过对候选文本和参考文本进行token级别的编码,并根据token编码的余弦相似度计算token级别的Precision。

近期,V神的论文去中心化社会,寻找web3的灵魂中提到的灵魂绑定Token SBT引起了热议这篇论文巧妙地引用了道德经中的概念,将去中心化组织DAO与道的概念相融合,赋予了SBT独特的意义SBT,即灵魂绑定代币,源于2022年初V神的“Soulbound”博客,其本质是与钱包绑定且不可转让的代币它由学校。

这种方法能够生成合适的大小的词汇表,能够学习有意义的tokens并处理unknown token的问题BPEByte Pair Encoding是一种简单的压缩算法,于2015年在论文Neural Machine Translation of Rare Words with Subword Units中被引入其思想是重复将文本中出现频率最高的字符对替换为文本中不存在的字符,从而实现文本压缩。

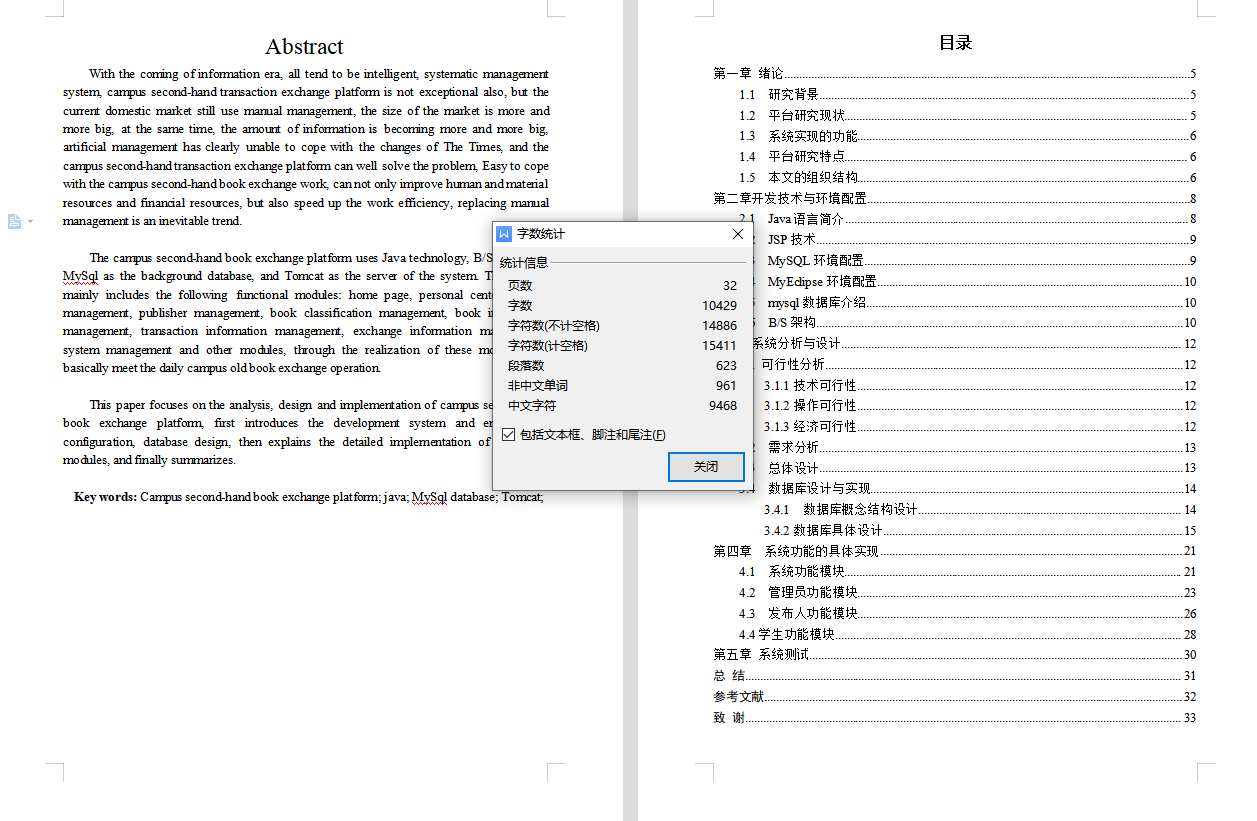

学术论文是某一学术课题在实验性理论性或观测性上具有新的科学研究成果或创新见解和知识的科学记录或是某种已知原理应用于实际中取得新进展的科学总结,用以提供学术会议上宣读交流或讨论或在学术刊物上发表或作其他用途的书面文件学术论文应提供新的科技信息,其内容应有所发现有所发明有。

9 TokenMixupTokenMixup基于Transformer中自有的attention机制计算每个图像token的显著性,再基于显著性结果,最大化整个batch数据mixup后的整体显著性本文介绍了CV领域9篇Mixup相关工作,从这些文章中可以看出Mixup数据增强方法的发展过程从最开始的简单插值,到后来的基于显著性的最优化mixup风格和内容。

单流模型如UNITER和ViLT,早期融合各模态信息,通过加和或拼接处理不同模态的Token,进行跨模态Attention交互这些模型强调早期融合,但ViLT通过简化设计减少了参数 多流模型如MulT和ViLBERT,每个模态有独立的Transformer Encoder,可以包含单模态SelfAttention或Crossmodal Attention,以适应不同交互需求。

GroupViT论文中,作者选择在Grouping模块的Token聚类中心选择上采用Gumbel Softmax方法,这主要是出于图像分割需求,确保每个类别对应一个且仅对应一个区域传统softmax难以实现这样的onehot分配,而Gumbel Softmax恰好解决了这个问题在项目GitHub上,有人曾疑惑为何不使用普通的softmax,因为softmax分配的是。

该研究旨在通过文本驱动图像生成,通过VQVAE技术将图像分割为固定数量的patch,训练patch与离散token索引的对应关系,将图像转化为等长的离散token序列,接着在离散序列上进行扩散和去噪过程论文创新点在于扩散模型部分,借鉴了D3PM的算法arxivorgpdf21070300,回顾了diffusion model的负对数。

我们深入探讨了大模型参数高效微调技术,以期对这一领域的核心原理有更深入的理解通过分析,我们了解到PTuning论文GPT Understands, Too这一方法将Prompt转换为可学习的Embedding层,并采用MLP+LSTM对Prompt Embedding进行处理与Prefix Tuning相比,PTuning引入了可微的virtual token,但限于输入层。

下面是我为大家整理的计算机网络技术 毕业 论文 范文 ,供大家参考 计算机网络技术毕业论文范文篇一 计算机网络技术的应用及发展思路 摘要目前在我国主要使用的LAN技术有Ethernet以太网TokenRing令牌环网和FDDI光纤分布式数据接口 32Internet Internet是一种国际互联形式的网络结构,是。

“PTuning Prompt Tuning Can Be Comparable to Finetuning Across Scales and Tasks”这篇论文发布于2022年5月,由清华大学北京智源AI研究院BAAI及上海期智研究院共同完成提示调优通过调整冻结的语言模型中的连续提示来实施,这实质上减少了每个任务在训练过程中的存储和内存使用量但先前的。

OneLLM One Framework to Align All Modalities with Language论文,提出了一种多模态大模型,旨在通过一个通用的encoder和通用的projection模块,实现多种模态信息与语言的对齐相较于以往的多模态大模型,OneLLM的两大优势在于一是整合多种模态,二是采用统一的encoder对不同模态进行处理,以提升。

这一部分的主要功能是实现图像分块和向量序列的生成例如,对于224x224的图像,将其分为16x16的小块patch,总共196个patch每个patch经过平坦化后,转换为长度为768的向量,形成196x768的二维矩阵,作为Transformer的输入序列格式此外,还有一个class embedding文中称为class token向量,其维度。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~